Antispidering

Was ist Spidering |

Spider sind Programme, welche automatisiert im Web surfen und dabei Daten sammeln. Während die Crawler der bekannten Suchmaschinen (wie Google, Bing oder Yahoo!) einfach Hyperlinks folgen und dabei Textinhalte indexieren, existieren auch spezialisierte Spider, welche sich einem bestimmten Thema widmen und dabei Daten in strukturierter Form sammeln, zum Beispiel Stellenangebote, Immobilien, käufliche Objekte oder Adressen. Während die Suchmaschinen auf den meisten Plattformen durchaus erwünscht sind - denn man will ja schliesslich gefunden werden - sieht es bei letzteren schon etwas anders aus. Beim Antispidering geht es vor allem darum, sowohl Suchmaschinen als auch menschliche Benutzer möglichst nicht zu behelligen, auf der anderen Seite aber alle unerwünschten Spider auszusperren. In der Praxis ist dies gar nicht so einfach, da viele unerwünschte Spider Tarnmechanismen einsetzen, um nicht entdeckt zu werden. |

Problematik |

Neben dem Betrieb von Suchmaschinen gibt es auch andere Motivationen zum Betrieb eines Spiders oder Crawlers:

In jedem Fall bedienen sich so die Spiderbetreiber kostenlos an wertvollen Daten, die sie sonst nicht oder nur teuer beschaffen könnten. Für Betreiber eines Online-Marktplatzes stellt der letzte Punkt die grösste Bedrohung dar. Dies lässt sich mit der allgemeinen Problematik beim Betrieb eines Marktplatzes erklären:

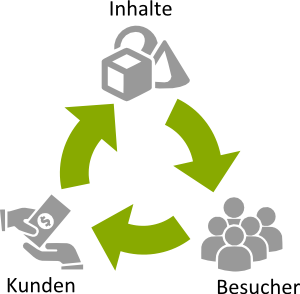

Nur eine Plattform mit attraktiven Inhalten zieht Besucher an. Eine gut besuchte Website wiederum hält das Geschäft der zahlenden Kunden am laufen, welche ihrerseits die benötigten Inhalte einstellen. Dieses Henne-Ei-Problem, welches sich beim Aufbau einer neuen Plattform oder auch bei der Stärkung der Marktposition stellt, lässt sich auch mit den grössten finanziellen Ressourcen nur teilweise lösen:

Ohne attraktive Inhalte verpuffen alle Marketing- und Verkaufsmassnahmen. Daher bleibt oft nur Spidering als einziges Mittel. Somit stellen die Inhalte das kostbarste Kapital einer Internet-Plattform dar, welches gegen aktuelle oder zukünftige Konkurrenz geschützt werden muss. |

Weitere Gefahren |

Während die Verteidigung der eigenen Marktposition den Hauptgrund für das Antispidering darstellt, gibt es auch noch andere Gründe, welche ebenfalls eine Rolle spielen

|

Gegenargumente |

Oft wird als Argument eingebracht, dass Spidering ja auch im Sinne der zahlenden Kunden sei, da dies die Reichweite der Objekte erhöhe und somit gut für desren Geschäft sei. Dies ist durchaus richtig, allerdings nur aus Sicht der Kunden. Für den Plattformbetreiber hat die Duldung, oder gar die Förderung von Spidering langfristig fatale Konsequenzen:

Diese Überlegungen gelten zweifellos für einen Marktführer. Aber auch kleinere Plattformen können mit einer Auswahl an exklusiven Inhalten genügend Attraktivität für einen Besuch bieten. Sind dieselben Inhalte jedoch auch andernorts verfügbar, erübrigt sich der Besuch. Es kann dennoch Fälle geben, in denen die Weitergabe von Daten an Partner oder Kunden unvermeidlich ist. In diesem Fall muss die Datenlieferung jedoch über kontrollierbare Schnittstellen abgewickelt werden. |

Die richtige Strategie |

Da Spidering eine existenzielle Bedrohung für jede Internetplattform darstellen kann, sollte eine strikte Abwehrstrategie im Vordergrund stehen:

Diese Vorgaben sollten so früh als möglich durchgesetzt werden. Je länger zugewartet wird, desto schwieriger wird es später. |

Rechtliche Lage |

Entgegen der allgemeinen Annahme, dass Spidering in der Schweiz erlaubt ist, stellt sich die Situation juristisch nicht so eindeutig dar. In der Branche erregte das Bundesgerichtsurteil im Jahr 2005 einige Aufmerksamkeit. Damals wurde die Klage eines Internetunternehmens gegen einen Spiderbetreiber in höchster Instanz abgewiesen. Dieses Urteil wurde allgemein als Freibrief für unbeschränktes Spidering angesehen. Dies ist aber nicht zutreffend. Es wurde lediglich festegstellt, dass der Spiderbetreiber in diesem konkreten Fall nicht gegen das UWG (Bundesgesetz gegen den unlauteren Wettbewerb) verstossen habe. So hat denn auch das Kantonsgericht Freiburg 2016 in einem neuen Urteil bei einer veränderten Ausgangslage dem Internetunternehmen recht gegeben und einem anderen Konkurrenten die Datenbeschaffung mittels Spidering verboten. Dieses Urteil wurde nicht ans Bundesgericht weitergezogen. Es ist zu erwähnen, dass in allen bisherigen Prozessen nur wegen Verstosses gegen das UWG geklagt wurde. Es sind jedoch auch Umstände denkbar, unter welchen auch das Urheberrechtsgesetz oder gar das Strafrecht Anwendung finden könnten. Auf der anderen Seite gibt es auch Formen des Spiderings, die unzweifelhaft als erlaubt und legal angesehen werden. So wäre das Internet, wie wir es kennen, ohne Suchmaschinen und deren Crawler schlicht nicht denkbar. Wo genau die Grenze zu ziehen ist, darüber werden sich Juristen wohl noch Jahrzehnte streiten. Zusammenfassend lässt sich sagen:

Aufgrund dieser unsicheren Rechtslage ist es nach wie vor empfehlenswert, technische Massnahmen gegen Spidering zu ergreifen. Ausserdem kann eine Antispidering-Lösung auch bei der Beweissicherung im Falle eines erneuten Prozesses helfen. |

Technische Massnahmen |

Auch leistungsfähige Firewall-Lösungen stossen bei der Verhinderung von Datendiebstahl mittels Spidern schnell an ihre Grenzen. Während sich beispielsweise Hacker-Angriffe gut abwehren lassen, versagen sie bei den meisten Spidern. Dies liegt daran, dass die Daten ja öffentlich zugänglich sein sollen, sowohl für jede Art von Internet-Client, wie auch für Suchmaschinen. Und ein Spider ist nichts anderes als ein automatisierter Internet-Client, welcher das Verhalten eines menschlichen Nutzers nachahmt. Somit musss ein technsicher Schutz vor Spidern auf Anwendungsebene angesiedelt sein. Ein Antispidering-System muss jeweils an die zu schützende Anwendung angepasst werden, was vertiefte Kentnisse sowohl über die zu schützenden Inhalte, als auch über zulässiges und unzulässiges Nutzerverhalten erfordert. |

Unsere Tools |

Uns stehen zwei Werkzeuge zur Verfügung, welche wir bei der Abwehr von Spideraktivitäten einsetzen:

Darauf aufbauend können wir nach Bedarf auch individualisierte Schutzlösungen entwickeln. |

Unser Knowhow |

Dank vieler Jahre Erfahrung kennen wir heute die meisten Tricks der Spider-Betreiber und können in den allermeisten Fällen effektive Massnahmen zum Schutz Ihrer kostbaren Daten in die Wege leiten. |

Unsere Dienstleistungen |

Wir unterstützen Sie beim Schutz Ihrer Daten:

|